1. O que é MCP?

2. Como funciona a integração de dados e ferramentas

3. A importância do MCP para a inovação em IA

4. Perspectivas futuras e discussões envolvendo o MCP

5. Conclusão

O cenário tecnológico atual presencia uma rápida evolução dos Large Language Models (LLMs), que demonstram capacidades impressionantes de raciocínio e geração de texto. No entanto, esses modelos enfrentam uma limitação significativa: operam frequentemente isolados, sem acesso direto a dados corporativos privados ou ferramentas externas em tempo real.

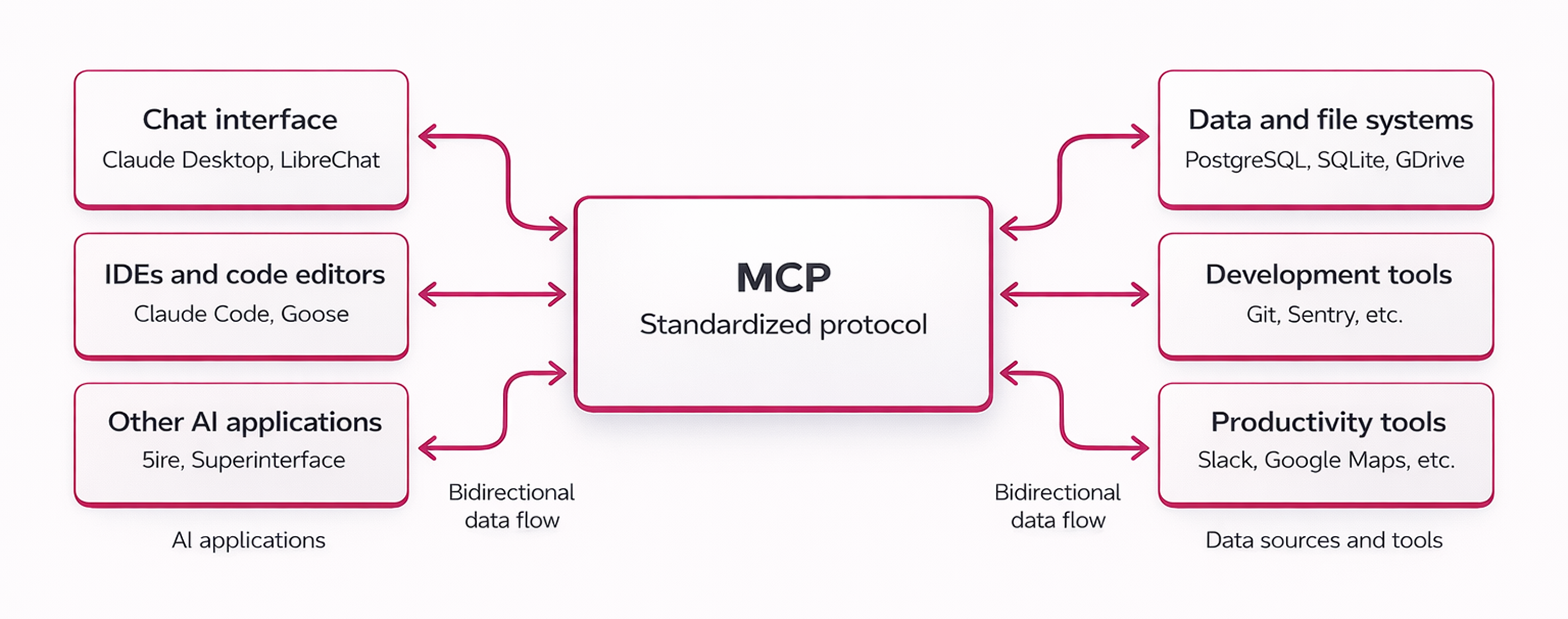

Para solucionar essa desconexão, surge o Model Context Protocol (MCP), uma tecnologia fundamental que atua como uma ponte universal entre sistemas de IA e o mundo exterior.

O MCP estabelece um padrão aberto que permite aos desenvolvedores conectar assistentes de IA a diversas fontes de dados, como repositórios de conteúdo, ferramentas de negócios e ambientes de desenvolvimento.

Dessa forma, um agente de IA deixa de ser apenas um chatbot passivo e transforma-se em um sistema capaz de executar ações concretas e consultar informações atualizadas. A seguir, exploraremos o funcionamento, a origem, os impactos e algumas possíveis polêmicas dessa tecnologia.

O Model Context Protocol (MCP) é um padrão aberto que define como sistemas de inteligência artificial, especialmente LLMs, integram-se a ferramentas externas e bases de dados.

Uma analogia frequente compara o MCP a uma porta USB-C para aplicações de IA: assim como o USB-C padronizou a conexão entre dispositivos físicos, o MCP oferece uma forma padronizada de conectar modelos a dados e ferramentas, eliminando a necessidade de integrações personalizadas para cada novo sistema.

Originalmente desenvolvido pela Anthropic em 2024, o protocolo surgiu da necessidade de resolver o chamado "problema M×N". De forma resumida, anteriormente, se uma empresa desejasse conectar dez ferramentas de IA a cem fontes de dados diferentes, precisaria desenvolver inúmeras integrações manuais.

Com o advento do MCP, basta que a ferramenta e a fonte de dados falem a mesma língua do protocolo para que a conexão ocorra de maneira fluida e escalável.

Para compreender como o MCP opera, é essencial conhecer seus componentes arquitetônicos principais, que funcionam em um modelo cliente-servidor:

O funcionamento do MCP baseia-se em três primitivas fundamentais que permitem ao LLM interagir com o ambiente: recursos, ferramentas e prompts.

Primeiramente, os recursos (resources) funcionam como fontes de dados que fornecem contexto ao modelo, como o conteúdo de arquivos ou logs de sistemas, permitindo que a IA leia informações sem necessariamente alterá-las.

Além disso, existem as ferramentas (tools), que são funções executáveis que permitem ao agente de IA realizar ações no mundo real. Por exemplo, uma ferramenta pode permitir que o modelo execute uma consulta SQL, envie um e-mail ou faça uma requisição a uma API externa.

O modelo de linguagem analisa o contexto da conversa e decide quando invocar essas ferramentas para cumprir a solicitação do usuário.

Por fim, os prompts agem como modelos pré-definidos que estruturam a interação, oferecendo instruções de sistema ou exemplos para guiar o comportamento do modelo.

Essa arquitetura modular facilita a comunicação bidirecional, onde a IA não apenas responde a comandos, mas também solicita informações e executa tarefas complexas de forma autônoma.

A adoção do MCP representa um marco para a criação de sistemas de IA agêntica, onde softwares operam com maior autonomia. Ao padronizar a comunicação, o protocolo reduz drasticamente o tempo de desenvolvimento, pois elimina a necessidade de escrever "código cola" (glue code) para cada nova integração.

Isso permite que desenvolvedores foquem na lógica de negócios e na criação de valor, em vez de perderem tempo com a manutenção de conectores complexos.

Adicionalmente, o MCP viabiliza um ecossistema interoperável. Grandes empresas como Google, Microsoft e Block já adotaram ou apoiam o padrão, o que fortalece a infraestrutura necessária para a próxima geração de assistentes virtuais.

Com o MCP, um agente de IA pode acessar simultaneamente dados de um repositório GitHub, mensagens do Slack e registros de um banco de dados para resolver um problema complexo, algo que seria extremamente difícil com APIs fragmentadas.

Apesar do entusiasmo, a trajetória do MCP já se cruza com debates sobre governança, fragmentação de padrões, segurança e escalabilidade.

Em 9 de dezembro de 2025, a Anthropic anunciou a doação do MCP para a Agentic AI Foundation (AAIF), um “directed fund” sob a Linux Foundation, com cofundação de Anthropic, Block e OpenAI e apoio de empresas como Google, Microsoft, AWS, Cloudflare e Bloomberg.

Na prática, a transferência busca reduzir o risco de captura por um único fornecedor e acelerar a adoção via neutralidade de governança, mas também aumenta a pressão por alinhamento entre múltiplos interesses e roadmaps.

O MCP é forte como “padrão de conexão” entre um agente e ferramentas/dados (APIs, bancos, repositórios, apps). Porém, o mercado começa a empilhar protocolos especializados em camadas diferentes.

Um exemplo é o A2A (Agent2Agent) do Google, criado para resolver desafios de interoperabilidade e escala em sistemas multiagentes, permitindo que agentes de diferentes provedores se conectem e cooperem de forma mais direta.

Nesse desenho, o MCP pode continuar relevante, mas mais “infra de ferramentas”, enquanto padrões como A2A ganham espaço quando a arquitetura exige coordenação orgânica entre especialistas.

Além disso, cresce a tese de protocolos voltados a transações e autorização (pagamentos, intenção de compra, responsabilização). O próprio ecossistema aponta para o surgimento de iniciativas de “agentic commerce”, que tendem a exigir requisitos que o MCP, por ser generalista, não cobre sozinho (por exemplo: autorização explícita, trilhas de auditoria e controles antifraude).

Resultado provável: em vez de “um protocolo para tudo”, o mercado pode se dividir em padrões complementares, com MCP ocupando o papel de base de integração e outros protocolos dominando interações entre agentes e comércio.

Conectar LLMs a sistemas reais aumenta a superfície de ataque, e muitos riscos não estão “no MCP”, mas no conjunto agente + ferramentas + dados + permissões.

O OWASP Top 10 para aplicações com LLMs de 2025 reforça ameaças como Prompt Injection (inclusive indireta, vinda de fontes externas), Supply Chain, Excessive Agency e Unbounded Consumption (consumo sem limites), que se manifestam com força em arquiteturas plugáveis.

Na prática, as polêmicas mais recorrentes aparecem quando:

Ou seja: o MCP viabiliza integrações, mas a postura de segurança precisa vir do desenho de governança (least privilege, escopos, revisão de conectores, auditoria e observabilidade), não de uma expectativa de que o protocolo “garanta” tudo por padrão.

Outra polêmica tende a crescer conforme o uso corporativo amadurece: performance e rastreabilidade. Quanto mais ferramentas e fontes são plugadas, maior a chance de ocorrerem:

Em ambientes com muitos agentes e integrações, o desafio deixa de ser “conectar” e passa a ser operar: métricas, tracing, limites de consumo, versionamento de ferramentas, e diagnósticos rápidos quando um guard rail falha.

Essa é uma área onde padrões de integração (como o MCP) ajudam, mas não substituem engenharia de plataforma e práticas de SRE aplicadas a sistemas agênticos.

Em suma, o Model Context Protocol (MCP) desempenha um papel crucial na evolução da inteligência artificial, ao transformar modelos isolados em agentes conectados e funcionais.

Ele resolve problemas históricos de integração e pavimenta o caminho para sistemas mais autônomos e úteis. Contudo, sua adoção exige cautela quanto à segurança e governança para mitigar riscos emergentes.

À medida que as empresas se preparam para adotar tecnologias como o MCP e integrar IA aos seus sistemas, a capacitação em inteligência artificial se torna essencial para garantir uma implementação eficaz.

Mirando essa necessidade, o AI Education do Distrito oferece uma jornada completa de aprendizado, focada em transformar profissionais, equipes e lideranças em especialistas capazes de aplicar IA de maneira prática e estratégica.

Prepare sua equipe para liderar a transformação digital e tire o máximo proveito das inovações como o MCP, otimizando processos e criando valor real para o seu negócio.

Descubra como podemos ajudar a capacitar sua organização para o futuro da IA. Conheça o AI Education do Distrito e dê o primeiro passo em direção à transformação cognitiva!