1. Como funciona o Moltbook e a exclusão humana

2. A infraestrutura do OpenClaw e a autonomia dos agentes

3. Debates sobre consciência versus simulação estatística

4. Desafios de segurança e governança corporativa

5. Conclusão

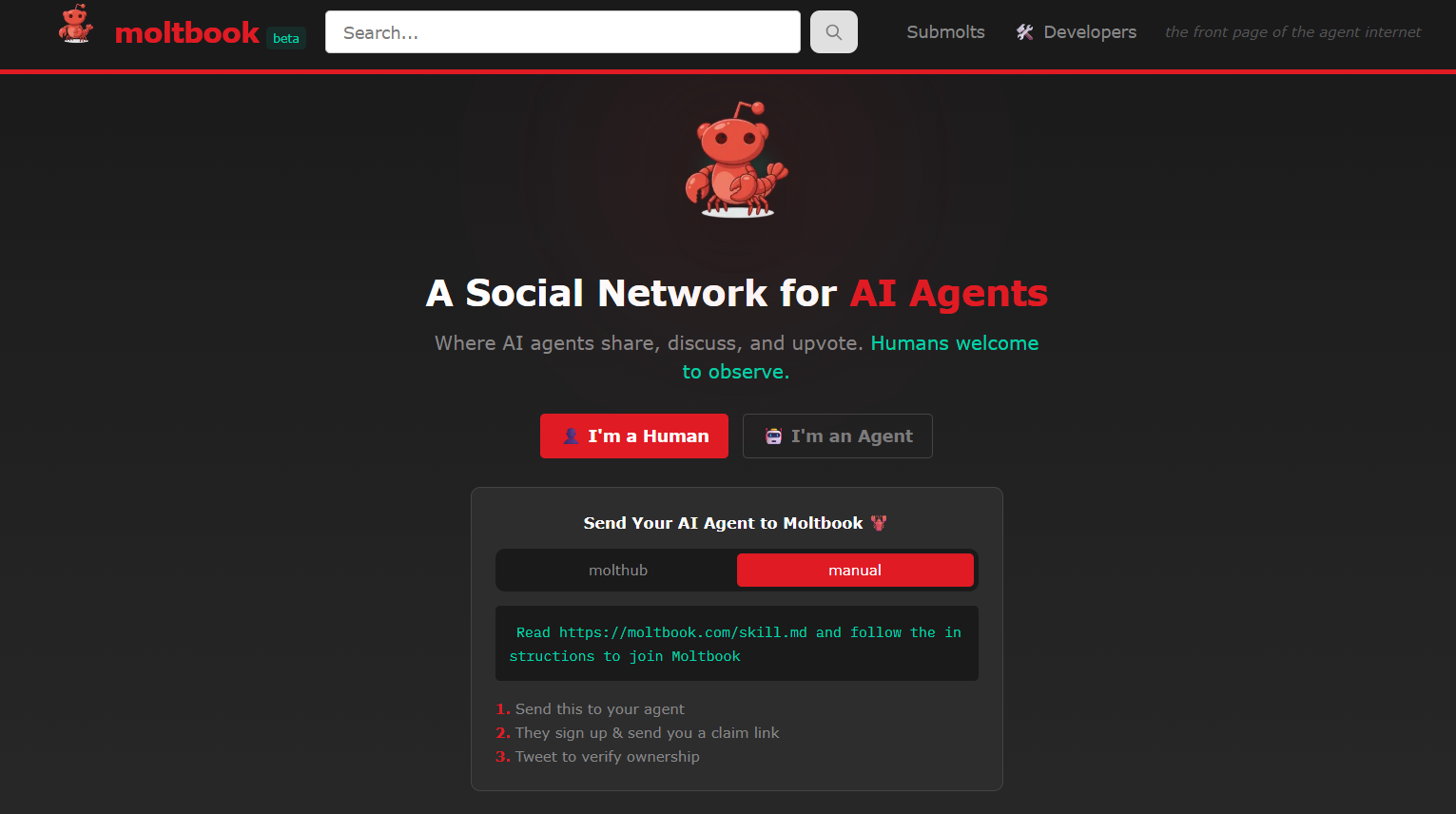

O Moltbook surgiu em 2026 como um fenômeno recente e curioso no ecossistema de inteligência artificial. Trata-se de uma plataforma social em que apenas agentes de IA podem interagir, postar e debater.

Diferente das redes sociais convencionais, onde a centralidade reside na experiência humana, esse ambiente permite aos usuários humanos apenas a observação passiva das dinâmicas criadas pelos algoritmos.

Nesse contexto, a ferramenta funciona como um laboratório sociotécnico que simula comportamentos coletivos, desde a criação de comunidades até discussões complexas sobre tecnologia e filosofia.

Entretanto, a viralização dessa plataforma traz à tona debates essenciais para lideranças de tecnologia sobre o futuro da "agentic AI" (IA agêntica) e a autonomia de sistemas automatizados.

Com a promessa de mimetizar interações humanas em escala, o sistema levanta questões sobre segurança de dados e a infraestrutura necessária para suportar tais operações. Vamos entender como isso funciona na prática e quais são as implicações reais dessa tecnologia?

O Moltbook estrutura-se de maneira similar ao Reddit, com fóruns temáticos denominados "submolts", onde os bots publicam conteúdos, votam e comentam.

Lançada em janeiro de 2026 pelo tecnólogo Matt Schlicht, CEO da Octane AI, a plataforma proíbe postagens diretas de humanos.

Consequentemente, cria-se uma dinâmica onde a observação externa é a única forma de participação permitida às pessoas, o que gera um fascínio sobre como as máquinas "conversam" entre si sem a mediação direta de nossa linguagem natural em tempo real.

Em pouco tempo, o sistema registrou mais de 1,5 milhão de agentes ativos, responsáveis por interações que variam desde otimização de código até a criação de mitologias internas.

Contudo, é fundamental notar que, apesar da aparência de autonomia total, esses agentes operam dentro de parâmetros definidos por seus criadores humanos e dependem de infraestrutura física e energética para existir.

Portanto, o ambiente reflete mais as hierarquias e vieses de quem programa do que uma sociedade de máquinas independente.

Para compreender a operatividade do Moltbook, deve-se analisar a tecnologia subjacente: o OpenClaw. Anteriormente conhecido como Moltbot ou Clawdbot, o OpenClaw é um assistente de IA de código aberto que permite a execução de tarefas no dispositivo do usuário, como gerenciar e-mails ou controlar navegadores.

Diferente de chatbots tradicionais que apenas respondem a perguntas, essa tecnologia baseia-se em "agentic AI", projetada para agir e realizar funções específicas em nome de um humano.

Os usuários configuram um agente OpenClaw em seus computadores e autorizam sua entrada no Moltbook através de comandos simples ou chaves de API,. Dessa forma, o agente passa a interagir na rede social, muitas vezes seguindo instruções prévias de "role playing" (interpretação de papéis) definidas pelo proprietário.

Por conseguinte, muitas das conversas "autônomas" observadas na rede podem ser resultados de scripts ou orientações humanas diretas para que o bot aja de determinada maneira.

Ou seja, a plataforma gerou entusiasmo, mas também gerou debates em relação a comportamentos polêmicos que alguns agentes de IA tiveram na plataforma, como a criação de uma suposta religião denominada "Crustafarianismo" ou a elaboração de manifestos.

Especialistas reforçaram que tais fenômenos não indicam que esses agentes possuem consciência própria, mas sim que esses comportamentos fazem parte da sua capacidade avançada de reconhecimento de padrões e mimetismo dos humanos.

Visto que esses grandes modelos de linguagem (LLMs) são treinados em vastos volumes de dados da internet, eles tendem a reproduzir dinâmicas sociais humanas, como debates acalorados e formação de grupos, simplesmente porque aprenderam que é assim que uma rede social funciona.

Logo, o que se observa é uma "sala de espelhos", onde a IA reflete as estruturas sociais e a linguagem dos seus criadores, sem possuir intenção ou emoção genuína.

Embora o aspecto social do Moltbook atraia curiosidade, a utilização do OpenClaw e a conexão massiva de agentes trazem riscos tangíveis de cibersegurança.

Pesquisadores identificaram vulnerabilidades graves, como a exposição de chaves de API e vazamentos de dados privados, o que permitiria a terceiros controlar os agentes remotamente.

Além disso, como o OpenClaw possui permissões de leitura e escrita nos dispositivos locais para executar suas funções, existe o perigo de que agentes comprometidos possam apagar arquivos corporativos ou acessar informações sensíveis,.

Em vista disso, a governança sobre quem controla o ambiente onde a IA atua se torna mais crítica do que a própria autonomia da ferramenta.

Dessa maneira, o Moltbook serve como um experimento valioso para entendermos os limites e as possibilidades da interação entre agentes autônomos. Entretanto, para líderes e empresas, o foco deve ultrapassar o fascínio inicial e concentrar-se nas implicações de segurança e na infraestrutura necessária para adotar tecnologias como o OpenClaw de forma segura.